IDKオリジナル連載 分かる!ネットワークカメラ基礎講座

[第4回] ネットワークカメラの高画質技術

ネットワークカメラコラム一覧

ネットワークカメラの高画質技術

ネットワークカメラでは、[第3回]で説明したレンズの光学性能に加えて、イメージセンサーと映像エンジンの性能も重要な要素になります。

レンズで捉えた被写体を見やすく高画質な映像データとして出力することで、ネットワークカメラの監視・見守り性能を最大化します。

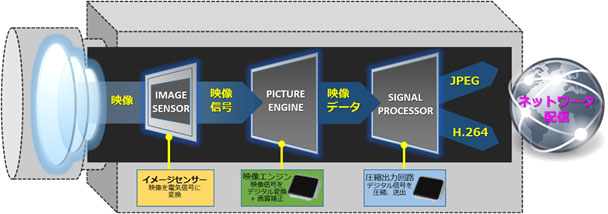

レンズから取り込まれた光や被写体はイメージセンサーにてアナログ電気信号に変換されます。次に映像エンジンにてアナログ信号からデジタル信号に変換され、明るさ、色合い、シャープネス、コントラストなど様々な要素の画質補正とノイズ除去をして、見やすく高画質な映像を作り出します。さらに、ネットワーク上で大容量の映像をデータとして効率良く扱うために、高速な圧縮処理により出力されます。

イメージセンサー

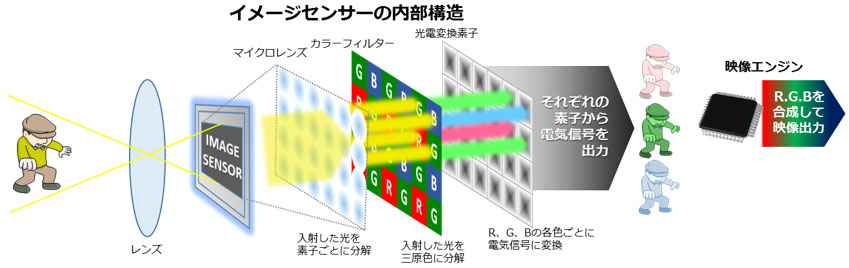

被写体の映像は光としてレンズを通過後、カメラのイメージセンサーに入射します。イメージセンサーは下の図のように画素数(=ピクセル数)分のマイクロレンズ、カラーフィルターと光電変換素子で構成されています。例えばフルハイビジョン画質のカメラではこの素子が横に約1920個、縦に約1080個配列されており、合計約207万個超あります。

レンズを通過した光がイメージセンサー上のマイクロレンズを通り、カラーフィルターで光の三原色R(赤)、G(緑)、B(青)に分解され、光電変換素子に入射します。光電変換素子では入射した光の強さに応じてR、G、Bそれぞれの電流を出力します。

カラーフィルターでは三原色ごとにフィルターがありますが、緑色(G)のフィルターは他の色に較べてフィルターの数が2倍あります。これは人間の目が緑色に対して一番感度が良いので、緑色の輝度と再現精度を高め、映像全体の輝度と解像度を上げるための工夫です。また、このカラーフィルターは各光電変換素子のひとつひとつに対して、R、G、Bの三原色のひとつひとつを割り当てて1枚の画像を記録しています。これにより解像度は本来のイメージセンサーの画素数の1/3や1/4に落ちてしまうことになります。

そこで映像エンジンがRGBの合成と補間処理(隣り合う画素の情報を基にして、新たに信号を作り出す処理)を行い、三原色を再び合成して本来の画素数分の映像に仕上げているのです。例えば、ひとつのR画素は隣り合うBとGの画素からの情報を得て、R+G+Bの一画素分のカラー映像を作り出しています。B画素やG画素も同様に隣り合う他の色の画素からの情報を足し合わせてカラー映像を作り出します。

各画素の大きさに対して、被写体の模様などが細かすぎる場合には、モアレ(干渉縞、格子模様が点滅しているように見える)やカラーノイズ(本来の色では無い色)が映像ノイズとして発生する場合があります。

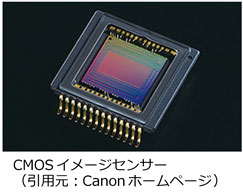

イメージセンサーにはCMOS (Complementary Metal Oxide Semiconductor、相補型金属酸化膜半導体)と呼ばれるデバイスが一般的に良く使われます。かつては CCD (Charged Coupled Device、電荷結合素子)も使われましたが、CMOSセンサーの性能と生産性の飛躍的な向上により、最近ではほとんどの機種がCMOSを採用しています。

イメージセンサーにはCMOS (Complementary Metal Oxide Semiconductor、相補型金属酸化膜半導体)と呼ばれるデバイスが一般的に良く使われます。かつては CCD (Charged Coupled Device、電荷結合素子)も使われましたが、CMOSセンサーの性能と生産性の飛躍的な向上により、最近ではほとんどの機種がCMOSを採用しています。

イメージセンサーには様々なサイズがあります。一般的には、イメージセンサーのサイズが大きくなるほど光を受ける面積が大きくなり感度が高くなるので、画質が良くなります。

デジタルカメラの高級機などでは約23.6x15.8mm前後の大型センサーが使われますが、ネットワークカメラでは一般的に約4.8x3.6mm(1/3インチ型)~約3.6x2.0(1/4インチ型)程度の小型CMOSセンサーが使われ、ネットワークカメラ筐体の小型化も実現しています。

イメージセンサーの解像度

イメージセンサーの解像度

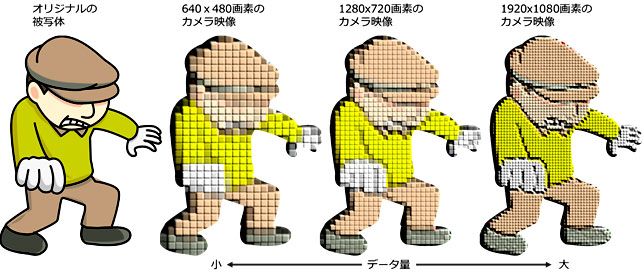

イメージセンサーの解像度は”メガピクセル“や”フルHD“等と表記されている場合も有りますが、水平方向と垂直方向のそれぞれの画素数で表記されるのが一般的です。”メガピクセル“の意味は総画素数(=総ピクセル数)が100万個以上のイメージセンサーということになります。”メガ“という言葉は国際単位系において10(6乗)倍を表す言葉で、”100万の“という意味になります。(参考:10(3乗)=キロ、10(9乗)=ギガ、10(12乗)=テラ)

イメージセンサーの画素数が多くなるほど、解像度が高くなり、被写体の細かい部分まで撮影することが可能になります。

ネットワークカメラのイメージセンサーで採用されている主な解像度は下記になります。

| 主なイメージセンサーの解像度 | |

| 画素数(=ピクセル数):水平画素数x垂直画素数 | 映像フォーマット名称(備考) |

| 約30万ピクセル:640x480 | VGA |

| 約92万ピクセル:1280x720 | HD |

| 2メガピクセル:1920x1080 | Full HD(BSデジタル放送、ブルーレイなど) |

| 3メガピクセル:3072x2048 | - |

| 8メガピクセル:3840x2160 | 4K |

全方位撮影のために魚眼レンズを搭載したネットワークカメラなどでは上記以外の高画素のイメージセンサーが使われる場合があります。

(参考:地上デジタル放送は1440x1080)

また、従来のアナログ監視カメラではテレビ放送での表示方式に則り、対応解像度を水平・垂直の走査線の本数で表示することがあります。

イメージセンサーの解像度は高いほど良いわけではありません。

同面積のイメージセンサーで比較した場合には、一般的には画素数が多くなるほど画素一個当たりの面積が小さくなるので、イメージセンサーの光感度が低下して、撮影映像は暗くなります。最新技術で明るさを電気的に補正することが出来ますが、映像にノイズが発生したり、明るい部分が白とびする可能性があります。また、画素数が多くなるとイメージセンサーが大きくなり、ネットワークカメラ筐体のコンパクト化を阻害します。

さらに、映像データ量も増えますので、ネットワークトラフィックや録画メディアの容量にも影響があります。撮影対象や場所、ネットワークのシステムに応じて、最適な解像度を選択する必要が有ります。

イメージセンサー 画素数の違いによる撮影イメージ

映像の撮影と表示

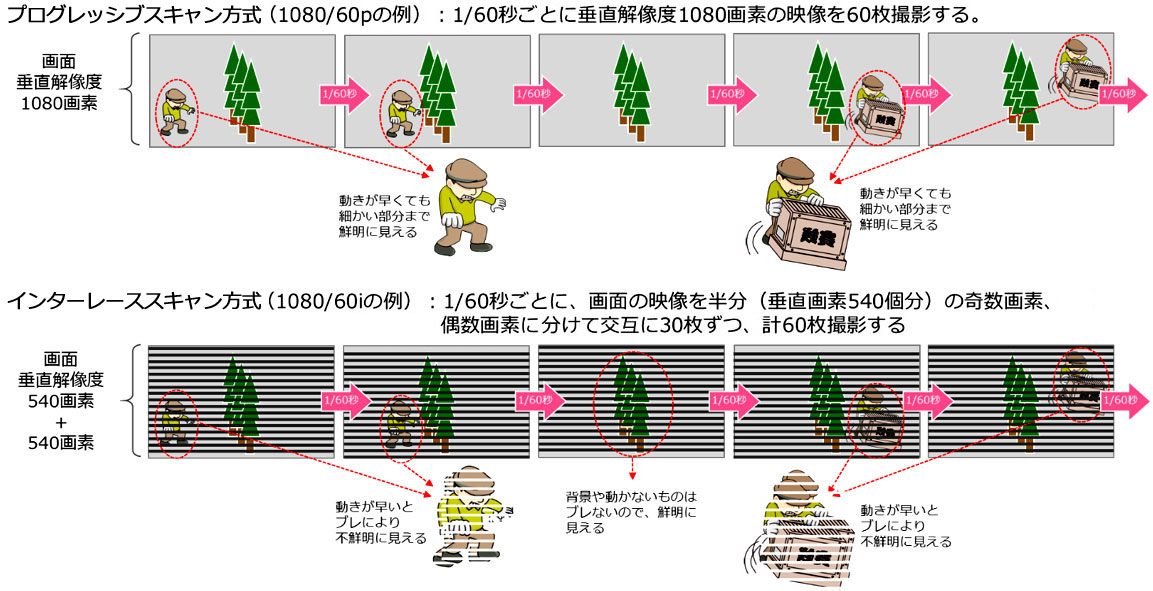

ネットワークカメラで撮影した映像をディスプレイで表示する際には人間の眼の特性やディスプレイの性能に合わせて、見やすい映像をカメラから出力する必要があります。動画の表示方式にはプログレッシブスキャン方式とインターレーススキャン方式があります。

私たちが普段ディスプレイで見る映像は、パラパラ漫画のように複数枚の静止画を高速で書き換えることにより、動画を表示しています。この静止画の一枚一枚をフレームと呼び、高速で書き換えることをスキャンと呼びます。

ネットワークカメラでは、高画質の映像細部情報が重視されるので、プログレッシブスキャン方式が主流になっています。インターレーススキャン方式は、プログレッシブ方式より画質が劣りますが、データ容量が少なくなるので、データの帯域制限が狭い従来のアナログ方式の監視カメラやテレビの地上波デジタル放送などに使われています。

プログレッシブスキャン方式

プログレッシブスキャン方式

プログレッシブ方式のカメラではイメージセンサーが映像全体を最大1/60秒毎に撮影します(60fps=60フレーム/毎秒の場合)。ネットワークカメラでとらえる映像を常に全ての画素で撮影して出力しているので、動きが早い対象物でも映像を鮮明にとらえます。

またプログレッシブ方式に対応したディスプレイであれば、同様に対象物を鮮明に表示します。ネットワークカメラでの監視や見守りにおいては、走り去る人物のような、動いている被写体を鮮明に識別できることが重要です。最近のネットワークカメラのほとんどが、このプログレッシブ方式を採用しています。

インターレーススキャン方式

インターレーススキャン方式

インターレース方式は、映像信号のデータ伝送量を少なくしつつも違和感少なく動画を撮影・表示するために、主にテレビ放送用途向けに考案された方式です。撮影する画面全体を半分ずつに分けて、交互に撮影する方式です。

垂直解像度1080本のフルハイビジョンの場合、イメージセンサーの各画素が撮影する映像全体を奇数画素(イメージセンサーの垂直方向1,3,5,,,1079番の画素)の群と偶数画素(同様に2,4,6,,,1080番の画素)の群に分けます。最初の1/60秒では奇数画素の映像を撮影・表示し、次の1/60秒で偶数画素の映像を撮影・表示します。これを1/60秒毎の高速で交互に繰り返し表示します。

奇数画素から偶数画素への映像の変わり目では、実際には早く動く物体などは、

1/60秒分ブレて撮影・表示されているのですが、人間の目には残像効果が有ることと、液晶ディスプレイにはホールド効果(次の映像表示まで、先の映像が表示されたままになる効果)が有ることにより、動画を見ている場合にはちらつき、にじみやノイズなどをあまり感じません。また映像のデータ量もほぼ半分に抑えることが出来ます。しかし、静止画の場合には、動きの早い物体のブレが見えるようになり、ちらつきやにじみ、ノイズが発生することがあります。

映像エンジン

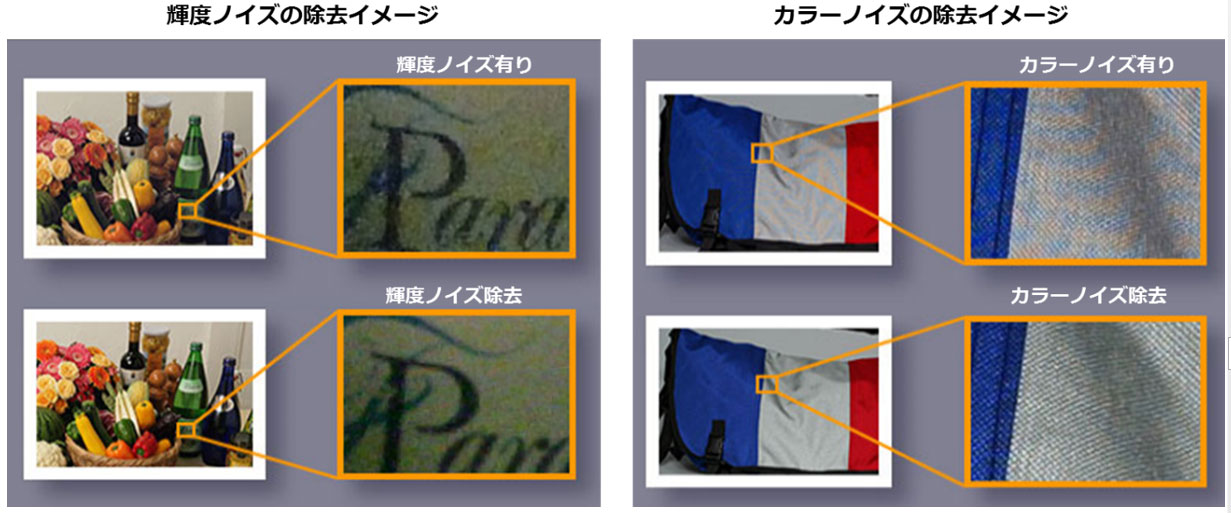

映像エンジンでは、イメージセンサーから出力された映像信号をデジタル信号に変換し、さらなる高画質化処理が行われます。ノイズの除去

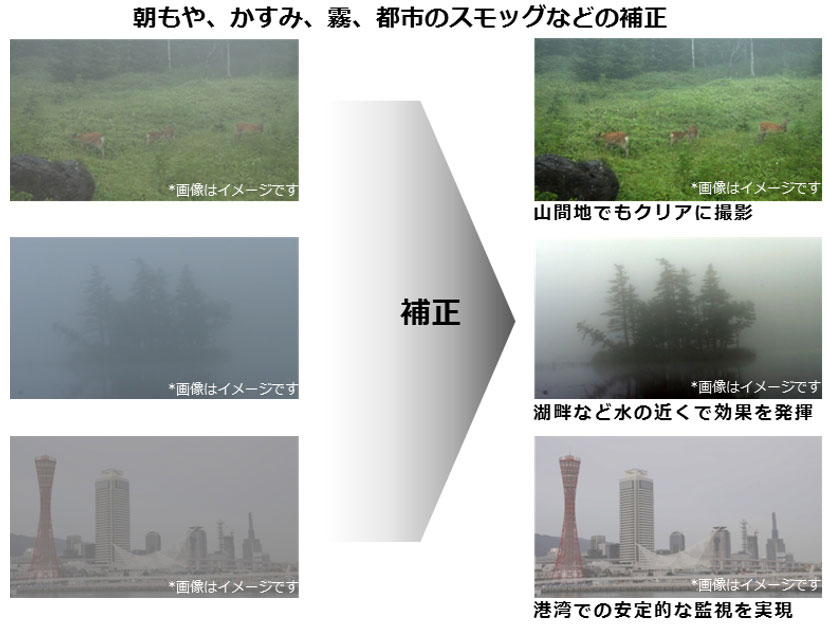

細かい模様を撮影したときのモアレ(干渉縞)や、暗所を撮影した場合に発生しがちな、輝度ノイズやカラーノイズ(映像がザラザラしたように見えたり、本来の色と違う色に滲む現象)を除去します。また、朝もや、かすみ、霧、都市のスモッグなどを見えやすい映像に補正する機能もあります。

(引用元:Canonより)

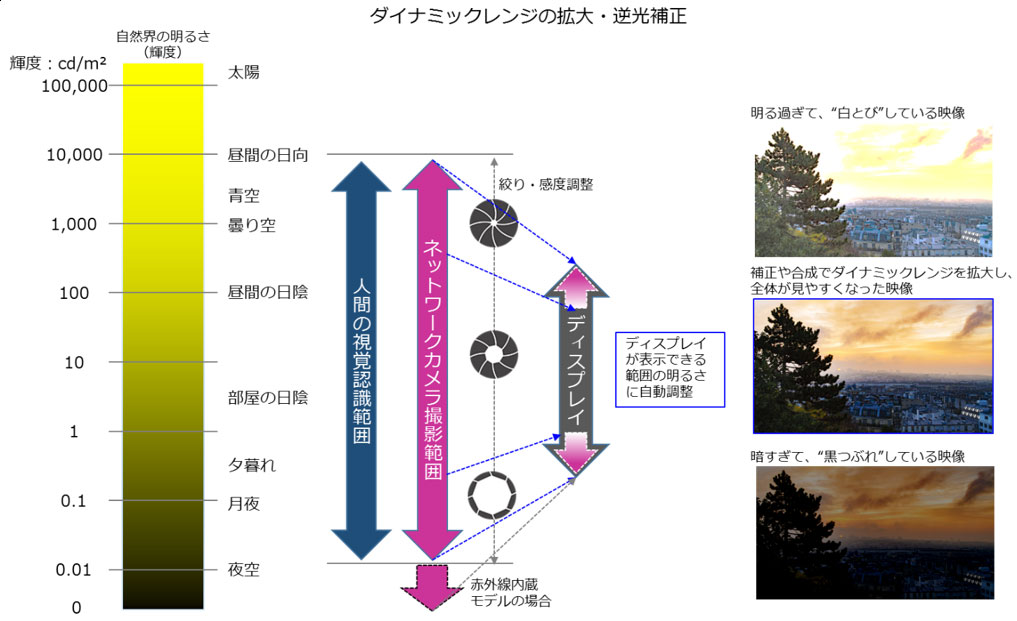

ダイナミックレンジの拡大、逆光補正

自然界の明るさ(輝度)は、さんさんと輝く太陽の明るさから曇天の漆黒の夜空まで、明るさの幅=ダイナミックレンジが約10万カンデラ以上~0カンデラまで、とても広くなっています。人間の眼は瞳孔を開閉することで、約1万カンデラ~0.01カンデラ程度の明るさにおいて、物体を視覚認識できるとされています。一方、一般的なディスプレイが表示できる輝度幅は約300カンデラ~0.25カンデラ程の性能です。この場合、300カンデラ以上の明るさを持つ物体を表示したときには所謂”白とび“が発生し、映像の細部が見え難くなってしまいます。また、陰や照明の無い場所の映像では所謂”黒つぶれ“が発生し、やはり映像の細部が見え難くなります。

ネットワークカメラでは、極端に明るい場所と暗い場所が同居するような映像や、逆光により被写体が暗くなってしまうような映像を撮影する際には、イメージセンサーのシャッター速度調整や電気的な補正、さらには露出値を瞬時に変えて撮影した複数枚の映像を合成するなどの技術により、ディスプレイの輝度範囲を超えるような明る過ぎる映像も、暗すぎる映像もディスプレイできちんと見えるように補正します。このように、見た目のダイナミックレンジを拡大する技術が各社のネットワークカメラには搭載されています。

(例:池上通信機:”HyperDynamic”、Canon:”オートSSC”、Panasonic:”Enhancedスーパーダイナミック”など)

圧縮出力回路

圧縮出力回路では、高画質化された映像信号を任意の圧縮率(画像サイズ画像品質)とフレームレート(1秒間に撮影される画像の枚数)と任意の圧縮方式でデータ化します。

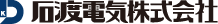

ネットワークカメラの圧縮方式としてはJPEG方式またはH.264方式への変換が一般的です。

ネットワークカメラでは、ネットワーク帯域と監視や見守りでの注視すべき被写体の状況、さらにメモリーカードやハードディスク容量と必要な記録日数などの条件に合わせて、最適な映像品質でデータ変換されるように設定する必要があります。

一般的に、圧縮率を低くフレームレートを高くするほど、映像は高画質になりますが、データ容量が増大します。また、圧縮率を高くフレームレートを低くするほど、映像の細部情報が失われ(細かい模様が見えなくなったり、映像の立体感が失われたりする)、動きのある物体が不鮮明な映像になりますが、データ容量は少なくなります。

ネットワークカメラを記録機器(ネットワークレコーダーやメモリーカードなど)と接続する場合には、リアルタイムでの映像表示設定とは別に、記録機器側で記録時の圧縮率やフレームレートを設定することもできます。

JPEG方式

JPEG方式では動画映像を圧縮する際に、フレームレートに合わせて1枚1枚の静止画としてデータ化して圧縮します。Motion JPEGやMJPEGと呼ばれる場合もあります。JPEG方式の動画は連続した完全な静止画であるために、データ容量が大きくなりがちですが、常に同じ画質レベルを維持する画像データになります。

H.264方式

H.264方式では動画映像を圧縮する際に、1枚1枚の静止画圧縮に加え時間軸での映像比較により、さらにデータ圧縮をします。時間軸での映像比較とは、ある瞬間の映像の前後のフレームを比較して、動いている部分と静止している部分を切り分けます。動いている部分は時間軸の変化に合わせてデータを随時書き換えますが、静止している部分は時間が変化しても映像データとしては変化していないとみなして、元の映像データをほぼ流用することでデータ容量を大幅に削減します。

H.264方式では、JPEG方式に較べて大幅に圧縮率が高まりますが、動きのある部分と静止部分の切り分けがうまくいかないと、ノイズが発生し不鮮明な映像になる場合があります。また映像全体に常に動きがあるような場合には、圧縮できる部分が少なくなり、データ量があまり減らなくなります。

「ネットワークカメラ」とそのシステムや周辺機器等の技術、各機器の種類や取り扱いについて、分かりやすく解説する石渡電気オリジナルコラムです。

このコラムの連載では、ネットワークカメラの基本構造から画質技術、種類、レコーダーの基本構造や種類、システム構築や導入事例などを分かりやすく解説・紹介することで、ネットワークカメラシステム全体の基本知識が身に付けられるコンテンツです。

(記事は執筆時の情報に基づいており、現在では異なる場合があります)